Компьютеры доминировали над людьми в играх один на один, таких как шахматы, на протяжении десятилетий, но заставить искусственный интеллект (ИИ) сотрудничать с товарищами по команде немного сложнее. Теперь исследователи проекта DeepMind от Google научили игроков искусственного интеллекта работать вместе в командах с людьми и другими компьютерами, чтобы участвовать в видеоигре Quake III Arena 1999 года.

Эдд Гент из Science сообщает, что когда у ИИ есть только один противник, он обычно делает это довольно хорошо, поскольку он только предвидит возможные движения одного ума. Но командная работа - это совсем другое дело, потому что она включает в себя действия, в которых компьютеры традиционно не хороши, например, прогнозирование поведения группы товарищей по команде. Чтобы сделать ИИ по-настоящему полезным, он должен научиться взаимодействовать с другими умственными способностями.

Команда Google DeepMind объясняет в своем блоге:

«Миллиарды людей населяют планету, каждый со своими собственными целями и действиями, но все же способен объединяться через команды, организации и общества в впечатляющих проявлениях коллективного разума. Эту настройку мы называем многоагентным обучением: многие отдельные агенты должны действовать независимо, но учиться взаимодействовать и взаимодействовать с другими агентами. Это чрезвычайно сложная проблема, потому что с коадаптирующимися агентами мир постоянно меняется ».

Многопользовательские видеоигры от первого лица, в которых команды игроков бегают по виртуальным мирам, обычно стреляя из ружей или гранатометов друг в друга, являются идеальным местом, где ИИ может изучить тонкости командной работы. Каждый игрок должен действовать индивидуально и делать выбор, который приносит пользу команде в целом.

Для исследования команда обучила ИИ играть флаг захвата на платформе Quake III Arena . Правила довольно просты: две команды сражаются на поле битвы, похожем на лабиринт. Цель состоит в том, чтобы захватить как можно больше виртуальных флагов других команд, защищая свои собственные, и та команда, которая захватит наибольшее количество флагов за пять минут, выиграет. На практике, однако, все может быть очень сложно быстро.

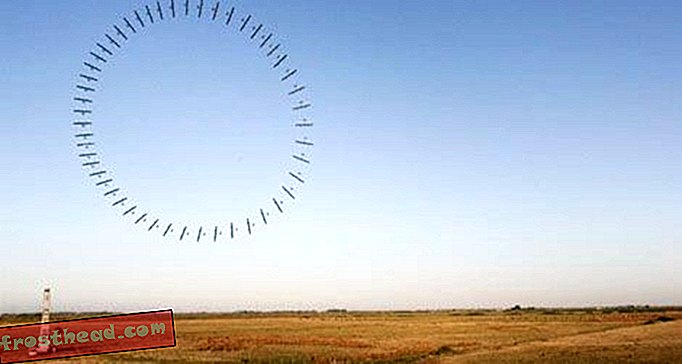

Команда DeepMind создала 30 алгоритмов нейронной сети и заставила их сражаться друг с другом на серии случайно сгенерированных игровых карт. Боты набирали очки, захватывая флаги и забивая других игроков, отправляя их обратно в зону возрождения, где их персонаж перезагружался. Сначала действия ботов казались случайными. Однако чем больше они играли, тем лучше они становились. Любые нейронные сети, которые постоянно проигрывали, были исключены и заменены модифицированными версиями победного ИИ. В конце 450 000 игр команда стала одной из нейронных сетей - получившей название «За победу» (FTW) - как чемпион.

Группа DeepMind сыграла алгоритм FTW против так называемых зеркальных ботов, которым не хватает навыков обучения ИИ, а затем против человеческих команд. FTW сокрушил всех претендентов.

Затем группа провела турнир, в котором 40 человек-игроков были случайно выбраны как товарищи по команде, так и противники бота. Согласно сообщению в блоге, игроки-люди обнаружили, что боты были более совместными, чем их настоящие товарищи по команде. Игроки-люди в паре с агентами FTW смогли победить кибер-воинов примерно в 5 процентах матчей.

Как они узнали, боты обнаружили некоторые стратегии, которые давно использовались людьми-игроками, такие как зависание возле точки возрождения флага, чтобы захватить его, когда он появится снова. Команды FTW также обнаружили ошибку, которую они могли использовать: если они стреляли в своего собственного товарища по команде в спину, это давало им ускорение, что они использовали в своих интересах.

«Что было удивительно во время разработки этого проекта, так это появление некоторых из этих поведений высокого уровня», - рассказывает Гент исследователь и ведущий автор DeepMind Макс Джадерберг. «Это вещи, к которым мы можем относиться как к людям».

Одна из главных причин, по которой боты были лучше, чем люди-игроки, заключается в том, что они были быстрыми и точными стрелками, что делало их быстрее на ничью, чем их человеческие противники. Но это был не единственный фактор их успеха. Согласно блогу, когда исследователи встроили в робо-шутеры время задержки реакции на четверть секунды, лучшие люди все еще могли победить их только в 21% случаев.

После этого первоначального исследования FTW и его потомки были задействованы на полях сражений на Quake III Arena и показали, что могут освоить еще более сложный мир с большим количеством опций и нюансов. Они также создали бота, который превосходит космическую стратегическую игру Starcraft II.

Но исследование не только о создании лучших алгоритмов видеоигр. Знание о командной работе может в конечном итоге помочь ИИ работать в автопарках или, возможно, когда-нибудь стать помощниками-роботами, которые помогут предугадать потребности хирургов, сообщает Science Gent.

Однако не все считают, что боты-аркады представляют собой настоящую командную работу. Исследователь искусственного интеллекта Марк Ридл из Технологии Джорджии сообщает The New York Times, что боты настолько хороши в игре, потому что каждый из них хорошо понимает стратегии. Но это не обязательно сотрудничество, так как командам ИИ не хватает одного важного элемента человеческой командной работы: общения и преднамеренного сотрудничества.

И, конечно же, им также не хватает другого признака опыта совместной видеоигры: мусор, говорящий другой команде.